Datenqualität erhöhen: Maßnahmen für verlässliche Analysen

Datenqualität ist die Grundlage verlässlicher Analysen. Dieser Artikel beschreibt praxisnahe Maßnahmen zur Verbesserung von Daten, von Governance und Integration bis zu Visualisierung und Automation, damit Dashboards und Reports zuverlässige Insights liefern.

Gute Datenqualität reduziert Fehlinterpretationen und steigert die Aussagekraft von Analysen. Unternehmen, die systematisch an Datenqualität arbeiten, gewinnen belastbare insights für Reporting, Attribution und Optimierung von Maßnahmen. Dieser Text erläutert konkrete Maßnahmen entlang der Datenerfassung, -verarbeitung und -visualisierung, damit Dashboards korrekte metrics zeigen und tracking-Fehler früh erkannt werden.

Wie verbessert Governance und Datenqualität?

Daten-Governance definiert Regeln für Datenerfassung, Nutzung und Speicherung. Klare Richtlinien für Namenskonventionen, Datenkataloge und Zugriffsrechte verhindern Inkonsistenzen. Ein Governance-Framework sollte Verantwortlichkeiten (Data Owners), Validierungsregeln und Perioden für Datenbereinigung festlegen. Regelmäßige Audits und Richtlinien zur Datenherkunft sichern die Verlässlichkeit von metrics und unterstützen Compliance. Dokumentation und Schulungen helfen Teams, Datenqualität als fortlaufende Aufgabe zu verstehen.

Wie sorgt Integration und Tracking für vollständige Daten?

Fehler im Tracking und in der Integration führen zu Lücken in den Datenpools. Einheitliche Tracking-Spezifikationen, standardisierte APIs und ein zentraler Event-Layer sorgen für konsistente Telemetry. Bei Integrationsprojekten sollten Datenmapping und Transformationen dokumentiert sowie automatische Tests für Tracking-Events eingerichtet werden. Monitoring von Ingest-Raten und Alerts bei Abweichungen hilft, Probleme frühzeitig zu erkennen und die Vollständigkeit von conversion- und performance-Daten zu sichern.

Welche Rolle spielen Metrics und Attribution?

Die Definition von metrics und Attributionslogiken beeinflusst direkt die Aussagekraft von Analysen. Einheitliche Metriken (z. B. Definition von Conversion) und klar dokumentierte Attribution-Modelle vermeiden Vergleichsfehler. Versionierung von KPIs, sowie Validierungs-Workflows für neue Metriken verhindern unbeabsichtigte Änderungen. Durch Segmentierte Auswertungen lässt sich prüfen, ob Attribution-Modelle in verschiedenen Kanälen ähnliche Erkenntnisse liefern oder angepasst werden müssen.

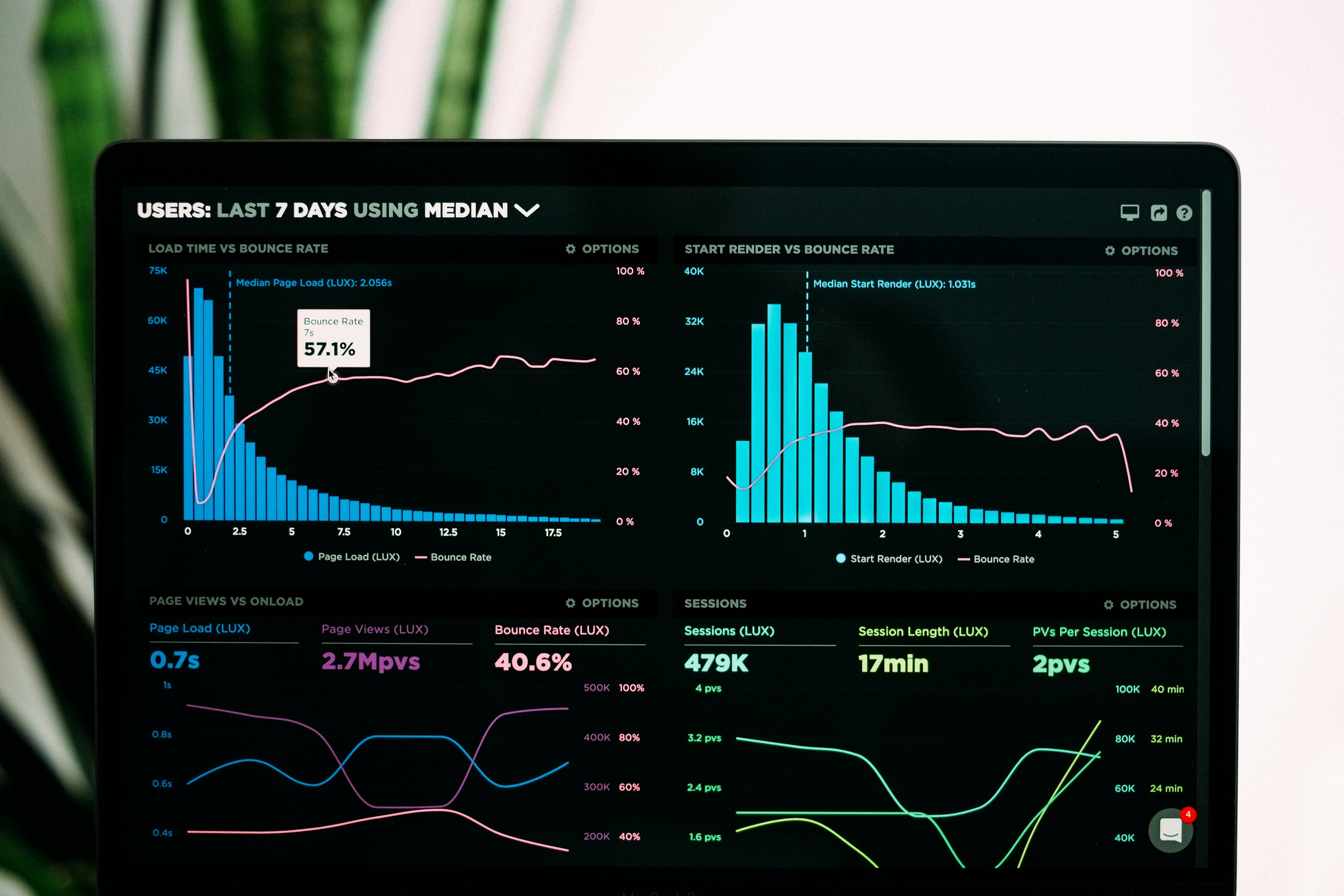

Wie unterstützt Dashboard-Visualisierung und Reporting?

Dashboards sollen komplexe Daten verständlich machen, ohne die Datenqualität zu überdecken. Gute Visualisierung zeigt Datenquellen, Aktualisierungszeitpunkte und Unsicherheitsbereiche. Automatisierte Reporting-Pipelines garantieren konsistente Datenzustände in Reports. Interaktive Dashboards mit Segmentierungsmöglichkeiten verbessern die Exploration von insights, während Meta-Informationen zu jedem Chart (Quelle, Refresh, Berechnungslogik) Vertrauen in die Zahlen stärken.

Wie helfen Automation, Telemetry und ABTesting bei Optimization?

Automation reduziert manuelle Fehler bei Datenverarbeitung und Reporting. Telemetry liefert kontinuierliche Signale über Systemzustand und Nutzerverhalten; automatisierte Checks prüfen Anomalien in time series oder sudden drops in conversion. Bei ABTesting sind standardisierte Experiment-Instrumentierungen und feste Analysepläne entscheidend, um verzerrte Ergebnisse zu vermeiden. Automatisierte Data-Pipelines mit Qualitätstests und Retries erhöhen die Zuverlässigkeit von performance-Analysen.

Wie fördern Segmentation, Conversion und Retention aussagekräftige Insights?

Segmentierung macht heterogene Nutzergruppen sichtbar und erhöht die Validität von Aussagen zur Conversion und Retention. Durch saubere Segment-Definitions und konsistente Channel-Zuordnungen lassen sich Unterschiede in Attribution und Verhalten korrekt messen. Retention-Analysen profitieren von einheitlichen Zeitfenstern und konsistenten Identifikatoren. Datenbereinigung (Duplikate, fehlerhafte IDs) ist für aussagekräftige cohort-Analysen und nachhaltige Optimierung unverzichtbar.

Schlussbemerkung: Verbesserung der Datenqualität ist ein fortlaufender Prozess, der technische Maßnahmen, Governance und kulturelles Commitment verbindet. Durch standardisierte Tracking-Spezifikationen, automatisierte Tests, klare Metrik-Definitionen und transparente Visualisierung lassen sich verlässlichere analyses ableiten. Kontinuierliches Monitoring und iterative Verbesserungen schaffen die Basis für belastbare insights, die Reporting und Optimierung fundiert unterstützen.