Modellinterpretation und Erklärbarkeit im Unternehmenskontext

Modellinterpretation und Erklärbarkeit sind zentrale Faktoren, wenn Unternehmen datengestützte Entscheidungen treffen. Dieser Artikel skizziert, wie klare Metriken, durchdachte Dashboards und solide Governance die Nachvollziehbarkeit von Modellen verbessern und damit operative und strategische Insights fördern.

Modelle liefern Prognosen und Vorschläge, doch ohne nachvollziehbare Interpretation bleiben viele Erkenntnisse für Stakeholder unverständlich. Im Unternehmenskontext bedeutet Erklärbarkeit, dass Fachabteilungen, Management und technische Teams die Logik hinter Vorhersagen nachvollziehen können. Gute Interpretierbarkeit verbindet modeling mit transparenter visualization, klaren metrics und robusten kpis, sodass Insights handhabbar und überprüfbar werden. Dies erhöht Vertrauen, erleichtert compliance und verbessert die Qualität von Entscheidungen über verschiedene Pipelines hinweg.

Welche Metriken (metrics) sind relevant?

Die Auswahl passender metrics und kpis ist die Grundlage jeder Modellinterpretation. Relevante Metriken umfassen nicht nur Vorhersagegüte wie Accuracy, Precision oder Recall, sondern auch Geschäftswerte wie Umsatzwachstum, Conversion-Rate oder Kosten pro Akquise. Für Explainability sollte man zusätzlich Feature-Importance-Metriken, Shapley-Werte oder LIME-Scores bereitstellen. Solche Kennzahlen verbinden technische Modellleistung mit den operativen Zielen des Unternehmens und liefern konkrete insights, die in Dashboards und Reports kommuniziert werden können.

Wie unterstützen Dashboards (dashboards) die Erklärbarkeit?

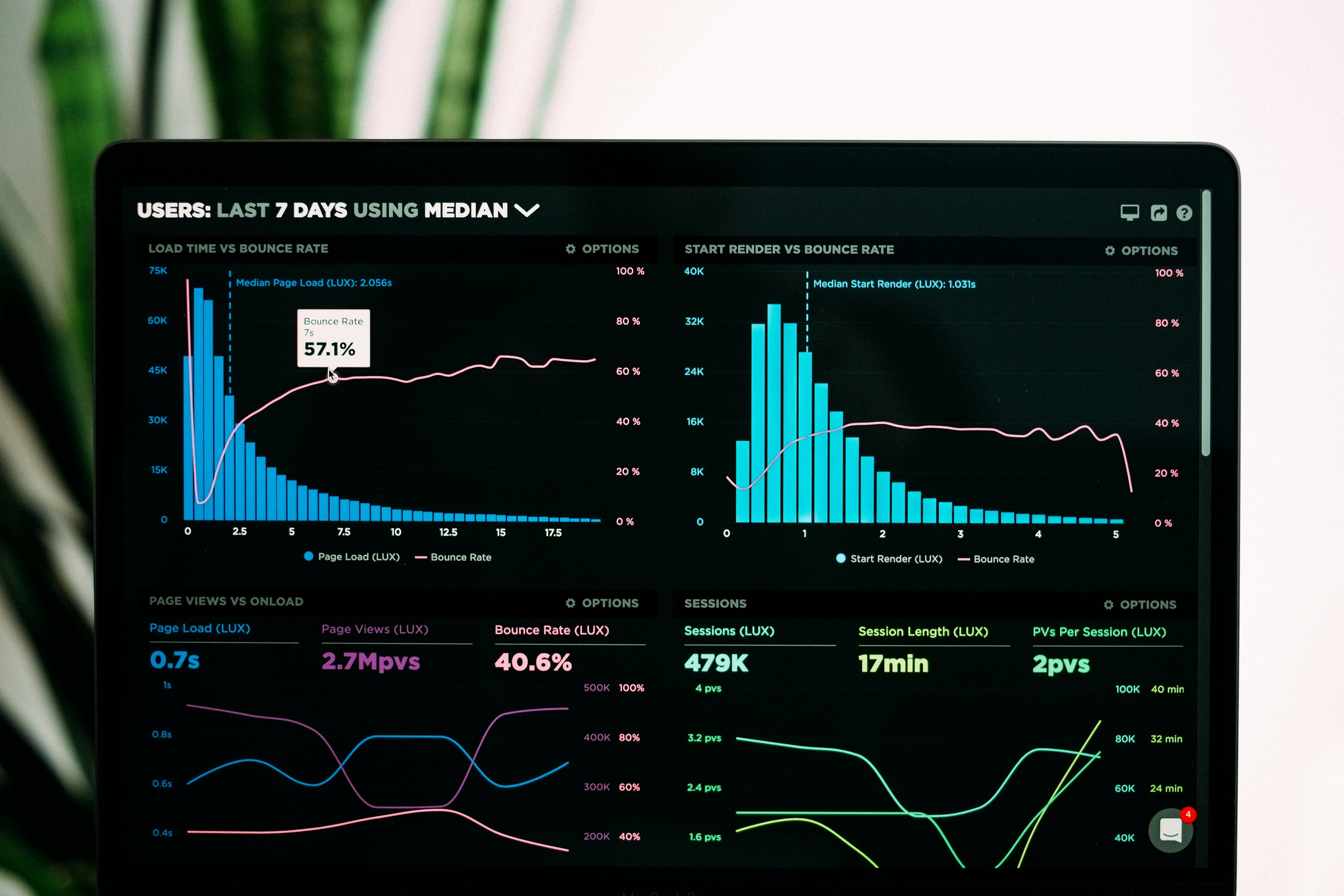

Dashboards übersetzen komplexe Modelloutputs in verständliche visualization und strukturierte KPIs. Interaktive Dashboards ermöglichen Drilldowns auf Segmente, zeigen Feature-Influences und erklären Abweichungen zwischen Forecasts und realen Ergebnissen. Durch ein Dashboard-Design, das neben Vorhersagen auch Unsicherheitsmaße und beschreibende Metriken darstellt, lassen sich Modelle besser überwachen und Interpretationen leichter nachvollziehen. Monitoring-Funktionen in Dashboards unterstützen die kontinuierliche Überprüfung von model drift und datenqualität.

Wie beeinflusst Forecasting (forecasting) die Interpretation?

Forecasting-Modelle brauchen transparente Annahmen, um interpretierbar zu bleiben. Erklärbare Forecasts legen Annahmen zur Saisonalität, externen Einflüssen und Modellparametern offen. Visualizations von Szenarien, Konfidenzintervallen und Fehlerverteilungen helfen Entscheidungsträgern, Risiken und Unsicherheiten abzuschätzen. Zudem wirken modellierung und optimization auf Vorhersagequalität: mit klar dokumentierten Trainingsdaten, Feature-Engineering und Validierungsstrategien wird das Verhalten von Forecasts nachvollziehbar.

Welche Rolle spielt Segmentation (segmentation) bei Einsichten?

Segmentation erlaubt zielgerichtete Interpretationen, indem Populationen nach Verhalten, Risiko oder Wert unterschieden werden. Modelle, die Segment-spezifische Leistungskennzahlen ausweisen, liefern präzisere insights und erklären, warum bestimmte Vorhersagen für eine Kundengruppe abweichen. Segmentbasierte visualization zeigt heterogene Effekte und unterstützt optimization-Maßnahmen, etwa Preis- oder Kampagnenanpassungen. Damit Segmentation wirkt, müssen Datenpipelines so aufgebaut sein, dass Segmentzuordnungen konsistent und transparent bleiben.

Wie tragen ETL und Pipelines (ETL, pipelines) zur Qualität bei?

Saubere ETL-Prozesse und robuste pipelines sind Voraussetzung für verlässliche Interpretationen. Datenvorbereitung, Validierung und Versionierung sollten automatisiert werden, damit Modelle auf reproduzierbaren Inputs basieren. Fehler in ETL können falsche Feature-Importances oder verzerrte forecasting-Ergebnisse verursachen. Automation reduziert manuelle Fehler und beschleunigt Monitoring, während Data Quality-Metriken dokumentieren, ob Inputs für Interpretationsmethoden ausreichend sind. Transparente Pipelines erleichtern zudem das Backtracking von Entscheidungen zu ihren Datenquellen.

Welche Governance- und Monitoring-Praktiken (governance, monitoring) sind nötig?

Governance sorgt dafür, dass Erklärbarkeitsanforderungen institutionell verankert werden: Richtlinien für Modelldokumentation, Reviewer-Boards und Compliance-Checks sind wichtig. Monitoring umfasst kontinuierliche Überwachung von Modellleistung, Drift, Datenqualität und fairness-Metriken. Regelmäßige Audits, Version-Control und klare Rollenverteilung zwischen Data Engineers, Data Scientists und Fachbereichen sichern nachhaltige Interpretierbarkeit. Nur mit etablierten Prozessen lassen sich Modelle verantwortungsvoll einsetzen und die gewonnenen insights operational nutzen.

Modellinterpretation und Erklärbarkeit sind keine reinen Technologiethemen, sondern organisatorische Herausforderungen. Durch die Kombination aus passenden metrics, durchdachten dashboards, erklärbarem forecasting und stabilen ETL-Pipelines entstehen nachvollziehbare insights, die Managemententscheidungen fundieren. Stabile governance- und monitoring-Strukturen sowie eine Kultur der Transparenz stellen sicher, dass modeling und optimization im Unternehmen verantwortungsvoll und wirkungsvoll eingesetzt werden.