Monitoraggio continuo per ottenere insight tempestivi

Il monitoraggio continuo trasforma flussi di dati in insight tempestivi, consentendo decisioni basate su metriche aggiornate e visibilità immediata. Integrando processi di ETL, pipeline automatiche, modelli di forecasting e dashboard di visualization, le organizzazioni possono ridurre i tempi di rilevamento di anomalie e migliorare la qualità del reporting. Questo approccio richiede governance, attenzione alla security e strategie di segmentation per garantire che gli insight siano rilevanti, interpretabili e utilizzabili in contesti operativi diversi.

Come ottenere insights tempestivi?

Per ottenere insights tempestivi è fondamentale trasformare i dati grezzi in informazioni fruibili con processi ripetibili. Le pipeline devono raccogliere, pulire ed elaborare i dati tramite ETL o ELT in modo da produrre metriche aggiornate. L’uso di metriche (metrics) coerenti e di reporting standardizzato consente ai team di confrontare performance nel tempo. Inoltre, una chiara strategia di governance definisce responsabilità e qualità dei dati, riducendo il rischio di insight fuorvianti. Infine, l’automazione dei processi evita ritardi umani e abilita risposte rapide a eventi critici.

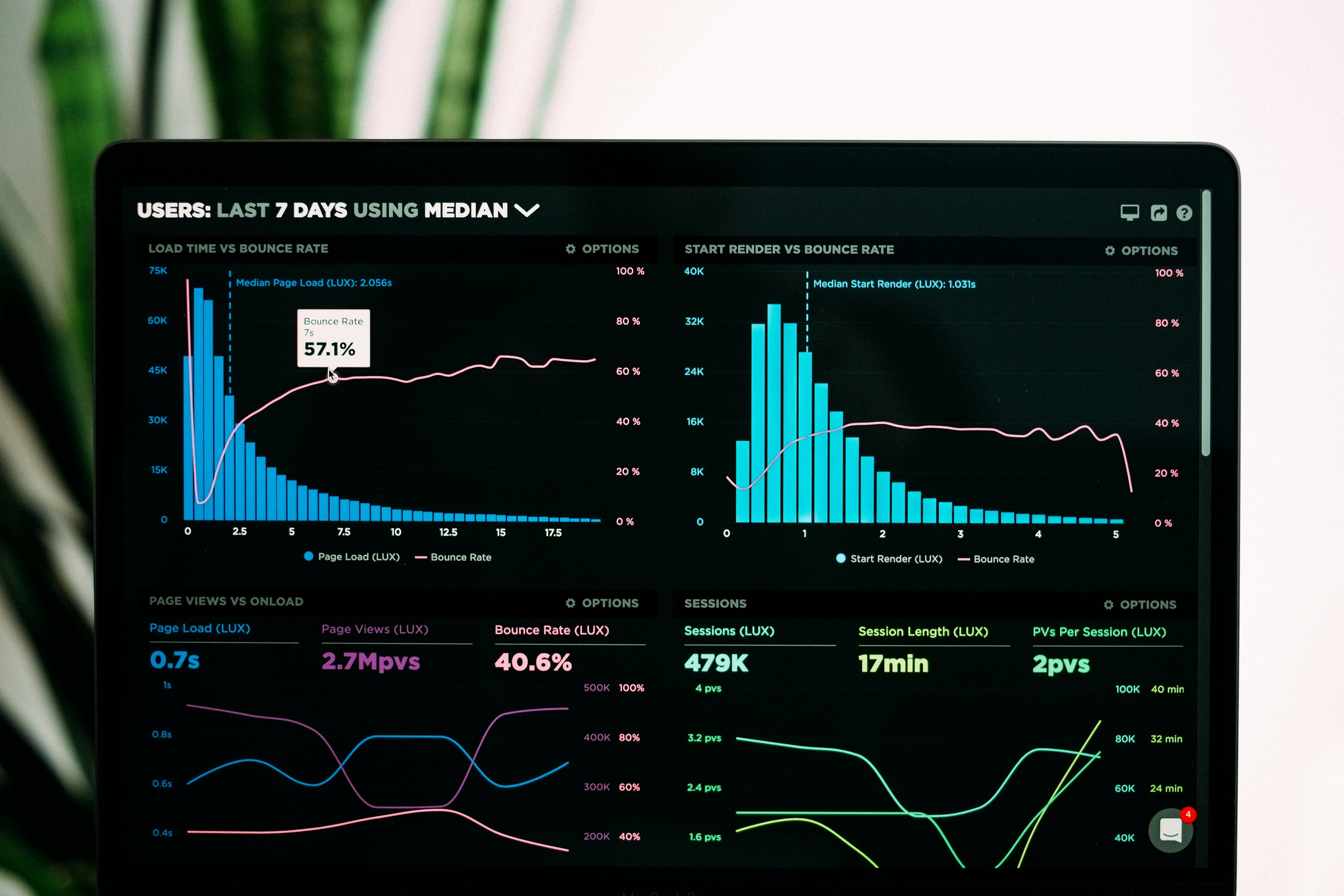

Quale ruolo ha la visualization nel monitoraggio?

La visualization rende accessibili gli insight anche a stakeholder non tecnici: dashboard e report interattivi sintetizzano pattern, trend e anomalie. Una buona visualizzazione supporta segmentation e drill-down per isolare cause e comunità di utenti. I grafici devono esporre metriche chiave in modo chiaro, con soglie e avvisi per evidenziare deviazioni. L’integrazione tra reporting e strumenti di alerting permette agli operatori di reagire immediatamente, migliorando i tempi di intervento rispetto a report statici o aggiornati in batch.

Come il bigdata influisce sui tempi di risposta?

Nel contesto bigdata, la sfida è gestire volumi e varietà senza sacrificare la velocità di analisi. Architetture basate su pipeline scalabili e storage ottimizzati consentono l’elaborazione in streaming o near‑real‑time. Tecniche di partitioning, compressione e indicizzazione migliorano le prestazioni delle query. Quando le risorse sono configurate per l’elaborazione continua, è possibile applicare modeling e forecasting anche su dataset estesi, abbattendo i tempi di latenza tra evento e insight. Tuttavia, la complessità richiede competenze e controlli di governance per mantenere qualità e coerenza.

Perché segmentation è cruciale per precisione?

La segmentation aiuta a contestualizzare i dati: suddividere utenti, prodotti o aree geografiche permette di identificare pattern significativi che altrimenti resterebbero nascosti in aggregati. Segmenti appropriati migliorano la precisione di forecasting e modeling, poiché i modelli possono adattarsi a comportamenti diversi. In fase di monitoring continuo, la segmentazione supporta alert più mirati e riduce i falsi positivi. Integrare metadata di segmentazione nelle pipeline e nei report assicura che gli insight siano azionabili a livello operativo.

Come usare forecasting e modeling per prevedere eventi?

Forecasting e modeling trasformano trend osservati in previsioni utili per pianificazione e risposta. Modelli statistici o basati su machine learning, addestrati su metriche storiche e variabili contestuali, possono stimare volumi futuri, richieste o rischi. È importante validare i modelli continuamente con nuovi dati provenienti dalle pipeline e aggiornare iperparametri quando le performance degradano. La combinazione di modelli diversi (ensemble) e l’uso di indicatori di confidenza migliorano l’affidabilità delle previsioni, supportando decisioni operative più rapide e informate.

Come garantire security, governance e resilienza delle pipelines?

Security e governance sono elementi essenziali del monitoraggio: controlli di accesso, cifratura dei dati in transito e a riposo, e audit trail proteggono la riservatezza e l’integrità degli insight. La governance definisce standard per quality checks, metadati e responsabilità sulla definizione delle metrics. Le pipelines devono essere resilienti, con monitoraggio dei job, retry automatici e alert su errori, oltre a test e validazioni continue. Implementare policy di data retention e compliance garantisce che reporting e analisi rispettino normative locali e requisiti aziendali.

Conclusione

Il monitoraggio continuo combina tecnologie, processi e governance per trasformare dati in insight tempestivi e utilizzabili. Integrare ETL, pipelines scalabili, visualization, segmentation, forecasting e controlli di security permette di mantenere metriche affidabili e ridurre i tempi di risposta. Il risultato è una maggiore capacità decisionale basata su informazioni aggiornate e contestualizzate, condizione necessaria per operare in ambienti competitivi e dinamici.